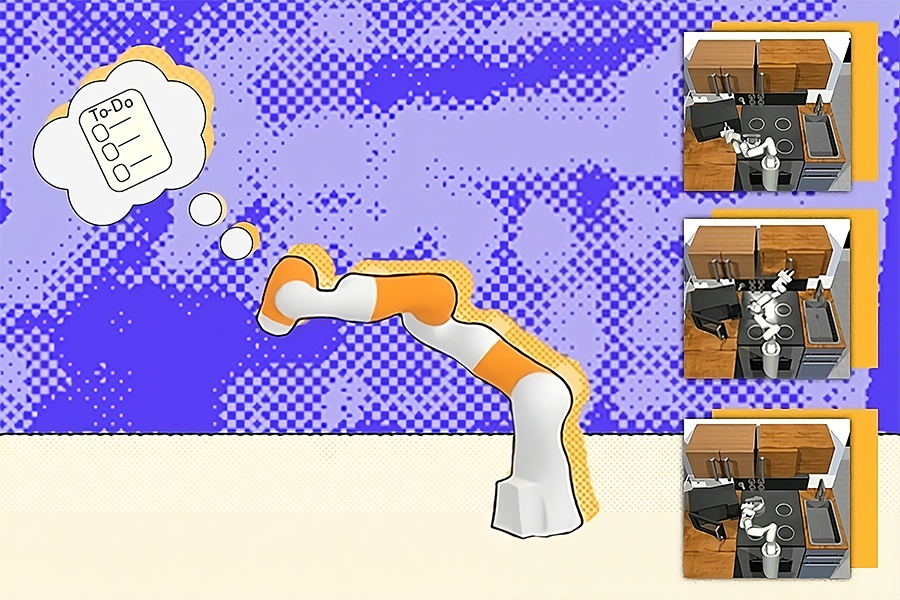

Un sistema multimodal utiliza modelos entrenados en lenguaje, visión y datos de acción para ayudar a los robots a desarrollar y ejecutar planes para tareas domésticas, de construcción y de fabricación

Fuente: Alex Shipps | MIT CSAIL

Es probable que su lista de tareas diarias sea bastante sencilla: lavar los platos, comprar alimentos y otras minucias. Es poco probable que hayas escrito «recoge el primer plato sucio» o «lava ese plato con una esponja», porque cada uno de estos pasos en miniatura dentro de la tarea parece intuitivo. Si bien podemos completar cada paso de forma rutinaria sin pensarlo mucho, un robot requiere un plan complejo que incluye esquemas más detallados.

El Improbable AI Lab del MIT, un grupo dentro del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL), ha ayudado a estas máquinas con un nuevo marco multimodal: Compositional Foundation Models for Hierarchical Planning (HiP), que desarrolla planes detallados y factibles con el experiencia en tres modelos de cimentación diferentes. Al igual que GPT-4 de OpenAI, el modelo básico sobre el que se construyeron ChatGPT y Bing Chat, estos modelos básicos se entrenan con cantidades masivas de datos para aplicaciones como generación de imágenes, traducción de texto y robótica.

A diferencia de RT2 y otros modelos multimodales que se entrenan con datos emparejados de visión, lenguaje y acción, HiP utiliza tres modelos básicos diferentes, cada uno de ellos entrenado con diferentes modalidades de datos. Cada modelo básico captura una parte diferente del proceso de toma de decisiones y luego trabaja en conjunto cuando llega el momento de tomar decisiones. HiP elimina la necesidad de acceder a datos combinados de visión, lenguaje y acción, que es difícil de obtener. HiP también hace que el proceso de razonamiento sea más transparente.

Lo que se considera una tarea diaria para un ser humano puede ser la “meta a largo plazo” de un robot (un objetivo general que implica completar muchos pasos más pequeños primero) que requiere datos suficientes para planificar, comprender y ejecutar objetivos. Si bien los investigadores de visión por computadora han intentado construir modelos básicos monolíticos para este problema, combinar datos de lenguaje, visuales y de acción es costoso. En cambio, HiP representa una receta multimodal diferente: un trío que incorpora de forma económica inteligencia lingüística, física y ambiental en un robot.

«Los modelos básicos no tienen por qué ser monolíticos», afirma el investigador de IA de NVIDIA, Jim Fan, que no participó en el artículo. “Este trabajo descompone la compleja tarea de la planificación de agentes encarnados en tres modelos constituyentes: un razonamiento lingüístico, un modelo del mundo visual y un planificador de acciones. Hace que un problema difícil de toma de decisiones sea más manejable y transparente”.

El equipo cree que su sistema podría ayudar a estas máquinas a realizar tareas domésticas, como guardar un libro o colocar un recipiente en el lavavajillas. Además, HiP podría ayudar con tareas de construcción y fabricación de varios pasos, como apilar y colocar diferentes materiales en secuencias específicas.

Evaluación de HiP

El equipo de CSAIL probó la agudeza de HiP en tres tareas de manipulación, superando a marcos comparables. El sistema razonó desarrollando planes inteligentes que se adaptan a la nueva información.

Primero, los investigadores le pidieron que apilara bloques de diferentes colores entre sí y luego colocara otros cerca. El problema: algunos de los colores correctos no estaban presentes, por lo que el robot tuvo que colocar bloques blancos en un recipiente de colores para pintarlos. HiP a menudo se ajustaba a estos cambios con precisión, especialmente en comparación con sistemas de planificación de tareas de última generación como Transformer BC y Action Difusor, ajustando sus planes para apilar y colocar cada cuadrado según fuera necesario.

Otra prueba: colocar objetos como dulces y un martillo en una caja marrón ignorando otros elementos. Algunos de los objetos que necesitaba mover estaban sucios, por lo que HiP ajustó sus planes para colocarlos en una caja de limpieza y luego en el contenedor marrón. En una tercera demostración, el robot pudo ignorar objetos innecesarios para completar objetivos secundarios de la cocina, como abrir un microondas, retirar una tetera y encender una luz. Algunos de los pasos indicados ya se habían completado, por lo que el robot se adaptó omitiendo esas instrucciones.

Una jerarquía triple

El proceso de planificación triple de HiP opera como una jerarquía, con la capacidad de entrenar previamente cada uno de sus componentes en diferentes conjuntos de datos, incluida información fuera de la robótica. Al final de ese orden hay un modelo de lenguaje grande (LLM), que comienza a idear capturando toda la información simbólica necesaria y desarrollando un plan de tarea abstracto. Aplicando el conocimiento de sentido común que encuentra en Internet, el modelo divide su objetivo en submetas. Por ejemplo, “preparar una taza de té” se convierte en “llenar una olla con agua”, “hervir la olla” y las acciones posteriores requeridas.

«Todo lo que queremos hacer es tomar modelos existentes previamente entrenados y hacer que interactúen exitosamente entre sí», dice Anurag Ajay, estudiante de doctorado en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación (EECS) del MIT y afiliado de CSAIL. “En lugar de presionar para que un modelo lo haga todo, combinamos varios que aprovechan diferentes modalidades de datos de Internet. Cuando se usan en conjunto, ayudan con la toma de decisiones robótica y potencialmente pueden ayudar con tareas en hogares, fábricas y sitios de construcción”.

Estos modelos también necesitan algún tipo de «ojos» para comprender el entorno en el que operan y ejecutar correctamente cada subobjetivo. El equipo utilizó un modelo de difusión de video de gran tamaño para aumentar la planificación inicial completada por el LLM, que recopila información geométrica y física sobre el mundo a partir de imágenes en Internet. A su vez, el modelo de video genera un plan de trayectoria de observación, refinando el esquema del LLM para incorporar nuevos conocimientos físicos.

Este proceso, conocido como refinamiento iterativo, permite a HiP razonar sobre sus ideas y recibir comentarios en cada etapa para generar un esquema más práctico. El flujo de retroalimentación es similar a escribir un artículo, donde un autor puede enviar su borrador a un editor y, con esas revisiones incorporadas, el editor revisa los últimos cambios y finaliza.

En este caso, la cima de la jerarquía es un modelo de acción egocéntrico, o una secuencia de imágenes en primera persona que infiere qué acciones deben tener lugar en función de su entorno. Durante esta etapa, el plan de observación del modelo de vídeo se mapea sobre el espacio visible para el robot, ayudando a la máquina a decidir cómo ejecutar cada tarea dentro del objetivo a largo plazo. Si un robot usa HiP para preparar té, esto significa que habrá trazado exactamente dónde están la olla, el fregadero y otros elementos visuales clave, y comenzará a completar cada subobjetivo.

Aun así, el trabajo multimodal está limitado por la falta de modelos básicos de vídeo de alta calidad. Una vez disponibles, podrían interactuar con los modelos de vídeo a pequeña escala de HiP para mejorar aún más la predicción de secuencias visuales y la generación de acciones robóticas. Una versión de mayor calidad también reduciría los requisitos de datos actuales de los modelos de vídeo.

Dicho esto, el enfoque del equipo de CSAIL solo utilizó una pequeña cantidad de datos en general. Además, HiP fue barato de entrenar y demostró el potencial de utilizar modelos básicos fácilmente disponibles para completar tareas a largo plazo. “Lo que Anurag ha demostrado es una prueba de concepto de cómo podemos tomar modelos entrenados en tareas y modalidades de datos separadas y combinarlos en modelos para la planificación robótica. En el futuro, HiP podría ampliarse con modelos previamente entrenados que puedan procesar el tacto y el sonido para hacer mejores planes”, afirma el autor principal Pulkit Agrawal, profesor asistente en EECS del MIT y director del Improbable AI Lab. El grupo también está considerando aplicar HiP para resolver tareas de robótica a largo plazo en el mundo real.

Ajay y Agrawal son los autores principales de un artículo que describe el trabajo . A ellos se unen los profesores del MIT y los investigadores principales de CSAIL, Tommi Jaakkola, Joshua Tenenbaum y Leslie Pack Kaelbling; Akash Srivastava, afiliado de investigación de CSAIL y director de investigación del MIT-IBM AI Lab; los estudiantes de posgrado Seungwook Han y Yilun Du ’19; el ex postdoctorado Abhishek Gupta, que ahora es profesor asistente en la Universidad de Washington; y el ex estudiante de posgrado Shuang Li PhD ’23.

El trabajo del equipo fue apoyado, en parte, por la Fundación Nacional de Ciencias, la Agencia de Proyectos de Investigación Avanzada de Defensa de EE. UU., la Oficina de Investigación del Ejército de EE. UU., la Oficina de Iniciativas de Investigación Universitaria Multidisciplinaria de Investigación Naval de EE. UU. y el Laboratorio de IA Watson del MIT-IBM. Sus hallazgos se presentaron en la Conferencia de 2023 sobre sistemas de procesamiento de información neuronal (NeurIPS).