Hace exactamente 200 años, un ingeniero francés introdujo una idea que permitiría cuantificar el inexorable deslizamiento del universo hacia la descomposición. Pero la entropía, tal como se la entiende actualmente, es menos un hecho sobre el mundo que un reflejo de nuestra creciente ignorancia. Aceptar esa verdad está llevando a un replanteamiento de todo, desde la toma de decisiones racional hasta los límites de las máquinas.

Por: Zack Savitsky-(Quanta)

La vida es una antología de destrucción. Todo lo que construyes acaba por romperse. Todos los seres queridos morirán. Todo sentido de orden o estabilidad se desmorona inevitablemente. El universo entero sigue un triste camino hacia un estado de confusión absoluta.

Para seguir la pista de esta descomposición cósmica, los físicos emplean un concepto llamado entropía. La entropía es una medida del desorden, y la declaración de que la entropía siempre está en aumento —conocida como la segunda ley de la termodinámica— es uno de los mandamientos más ineludibles de la naturaleza.

Desde hace mucho tiempo me persigue la tendencia universal al desorden. El orden es frágil. Se necesitan meses de cuidadosa planificación y maestría para crear un jarrón, pero un instante para demolerlo con un balón de fútbol. Pasamos la vida luchando por dar sentido a un mundo caótico e impredecible, donde cualquier intento de establecer el control parece ser contraproducente. La segunda ley exige que las máquinas nunca pueden ser perfectamente eficientes, lo que implica que siempre que surge una estructura en el universo, en última instancia solo sirve para disipar aún más la energía, ya sea una estrella que finalmente explota o un organismo vivo que convierte el alimento en calor. Somos, a pesar de nuestras mejores intenciones, agentes de la entropía .

“Nada en la vida es seguro excepto la muerte, los impuestos y la segunda ley de la termodinámica”, escribió Seth Lloyd, físico del Instituto Tecnológico de Massachusetts. No hay forma de eludir esta directiva. El crecimiento de la entropía está profundamente entrelazado con nuestras experiencias más básicas, lo que explica por qué el tiempo avanza y por qué el mundo parece determinista en lugar de incierto desde el punto de vista de la mecánica cuántica .

Pero a pesar de su importancia fundamental, la entropía es quizás el concepto más divisivo en física. “La entropía siempre ha sido un problema”, me dijo Lloyd. La confusión surge en parte de la forma en que el término se usa y se retuerce entre disciplinas: tiene significados similares pero distintos en todo, desde la física hasta la teoría de la información y la ecología. Pero también se debe a que comprender verdaderamente la entropía requiere dar algunos saltos filosóficos profundamente incómodos.

A lo largo del siglo pasado, los físicos han trabajado para unir campos aparentemente dispares y han arrojado una nueva luz sobre la entropía: han vuelto a enfocar al observador con el microscopio y han cambiado la noción de desorden por una de ignorancia. La entropía no se considera una propiedad intrínseca a un sistema, sino una propiedad relativa a un observador que interactúa con ese sistema. Esta visión moderna arroja luz sobre el profundo vínculo entre la información y la energía, que ahora está ayudando a marcar el comienzo de una minirrevolución industrial en la escala más pequeña.

Doscientos años después de que se sembraran por primera vez las semillas de la entropía, lo que está surgiendo es una concepción de esta cantidad que es más oportunista que nihilista. La evolución conceptual está cambiando radicalmente la antigua forma de pensar, no sólo sobre la entropía, sino sobre el propósito de la ciencia y nuestro papel en el universo.

La fuerza motriz del fuego

La noción de entropía surgió de un intento de perfeccionar la maquinaria durante la revolución industrial. Un ingeniero militar francés de 28 años llamado Sadi Carnot se propuso calcular la eficiencia máxima de la máquina de vapor. En 1824, publicó un libro de 118 páginas El libro de Carnot, titulado Reflexiones sobre la fuerza motriz del fuego , fue vendido en las orillas del Sena por tres francos. La comunidad científica no prestó demasiada atención a su libro y Carnot murió varios años después de cólera. Su cuerpo fue quemado, al igual que muchos de sus escritos. Pero sobrevivieron algunos ejemplares de su libro y en ellos se encuentran las brasas de una nueva ciencia de la termodinámica: la fuerza motriz del fuego.

Carnot se dio cuenta de que la máquina de vapor es, en esencia, una máquina que explota la tendencia del calor a fluir de los objetos calientes a los fríos. Diseñó la máquina más eficiente concebible, estableciendo un límite a la fracción de calor que se puede convertir en trabajo, un resultado que ahora se conoce como el teorema de Carnot. Su declaración más importante aparece como advertencia en la última página del libro: “No deberíamos esperar utilizar nunca en la práctica toda la fuerza motriz de los combustibles”. Siempre se disipará algo de energía a través de la fricción, la vibración u otra forma no deseada de movimiento. La perfección es inalcanzable.

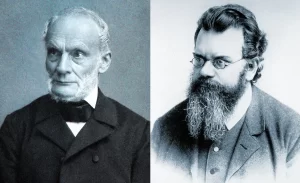

Unas décadas después, en 1865, el físico alemán Rudolf Clausius, al leer el libro de Carnot, acuñó un término para la proporción de energía que está atrapada en la futilidad. Lo llamó “entropía”, a partir de la palabra griega que significa transformación. Luego expuso lo que se conocería como la segunda ley de la termodinámica: “La entropía del universo tiende a un máximo”.

Los físicos de la época creían erróneamente que el calor era un fluido (llamado “calórico”). En las décadas siguientes, se dieron cuenta de que el calor era más bien un subproducto del choque de moléculas individuales. Este cambio de perspectiva permitió al físico austríaco Ludwig Boltzmann reformular y afinar la idea de la entropía utilizando probabilidades.

Boltzmann distinguió las propiedades microscópicas de las moléculas, como sus posiciones y velocidades individuales, de las propiedades macroscópicas de un gas, como la temperatura y la presión. Consideremos, en lugar de un gas, un grupo de piezas de juego idénticas en un tablero de ajedrez. La lista de coordenadas exactas de todas las piezas es lo que Boltzmann llamó un “microestado”, y su configuración general (ya sea que formen una estrella, por ejemplo, o estén todas agrupadas) es un “macroestado”. Boltzmann definió la entropía de un macroestado dado en términos del número de posibles microestados que lo originan. Un macroestado de alta entropía es aquel que tiene muchos microestados compatibles (muchas posibles disposiciones de las piezas que dan lugar a ese mismo patrón general).

Hay un número limitado de formas en las que las fichas pueden adoptar formas específicas que parezcan ordenadas, mientras que hay muchas más formas en las que pueden verse dispersas aleatoriamente por el tablero. Por lo tanto, la entropía puede considerarse una medida del desorden. La segunda ley se convierte en una afirmación probabilística intuitiva: hay más formas de que algo parezca desordenado que limpio, por lo que, a medida que las partes de un sistema se barajan aleatoriamente entre diferentes configuraciones posibles, tienden a adoptar disposiciones que parecen cada vez más desordenadas.

El calor en la máquina de Carnot fluye de caliente a frío porque es más probable que las partículas de gas estén todas mezcladas en lugar de segregadas por velocidad (con las partículas calientes y de movimiento rápido en un lado y las frías y de movimiento lento en el otro). El mismo razonamiento se aplica a por qué el vidrio se rompe, el hielo se derrite, los líquidos se mezclan y las hojas se descomponen. De hecho, la tendencia natural de los sistemas a pasar de estados de baja entropía a estados de alta entropía parece ser lo único que imbuye al universo de manera fiable de una dirección temporal consistente. La entropía graba una flecha del tiempo para procesos que de otro modo sucederían con la misma facilidad a la inversa.

La idea de la entropía acabaría extendiéndose mucho más allá de los confines de la termodinámica. “Cuando Carnot escribió su artículo… no creo que nadie imaginara lo que resultaría de él”, afirmó Carlo Rovelli, físico de la Universidad de Aix-Marsella.

Ampliando la entropía

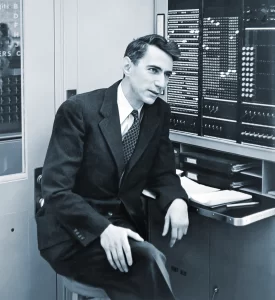

La entropía experimentó un renacimiento durante la Segunda Guerra Mundial. Claude Shannon, un matemático estadounidense, estaba trabajando para cifrar los canales de comunicación, incluido el que conectaba a Franklin D. Roosevelt y Winston Churchill. Esa experiencia lo llevó a pensar profundamente sobre los fundamentos de la comunicación durante los años siguientes. Shannon intentó medir la cantidad de información contenida en un mensaje. Lo hizo de una manera indirecta, al tratar el conocimiento como una reducción de la incertidumbre.

A primera vista, la ecuación que ideó Shannon no tiene nada que ver con las máquinas de vapor. Dado un conjunto de caracteres posibles en un mensaje, la fórmula de Shannon define la incertidumbre sobre qué carácter aparecerá a continuación como la suma de la probabilidad de que aparezca cada carácter multiplicada por el logaritmo de esa probabilidad. Pero si cualquier carácter es igualmente probable, la fórmula de Shannon se simplifica y se convierte en exactamente la misma que la fórmula de Boltzmann para la entropía. El físico John von Neumann supuestamente instó a Shannon a llamar a su cantidad “entropía”, en parte porque se alineaba estrechamente con la de Boltzmann, pero también porque “nadie sabe qué es realmente la entropía, por lo que en un debate siempre tendrás la ventaja”.

A primera vista, la ecuación que ideó Shannon no tiene nada que ver con las máquinas de vapor. Dado un conjunto de caracteres posibles en un mensaje, la fórmula de Shannon define la incertidumbre sobre qué carácter aparecerá a continuación como la suma de la probabilidad de que aparezca cada carácter multiplicada por el logaritmo de esa probabilidad. Pero si cualquier carácter es igualmente probable, la fórmula de Shannon se simplifica y se convierte en exactamente la misma que la fórmula de Boltzmann para la entropía. El físico John von Neumann supuestamente instó a Shannon a llamar a su cantidad “entropía”, en parte porque se alineaba estrechamente con la de Boltzmann, pero también porque “nadie sabe qué es realmente la entropía, por lo que en un debate siempre tendrás la ventaja”.

Así como la entropía termodinámica describe la eficiencia de un motor, la entropía de la información captura la eficiencia de la comunicación. Se corresponde con el número de preguntas de sí o no necesarias para descifrar el contenido de un mensaje. Un mensaje de alta entropía es un mensaje sin patrón; sin una manera de adivinar el siguiente carácter, el mensaje requiere muchas preguntas para ser revelado por completo. Un mensaje con muchos patrones contiene menos información y es más fácil de adivinar. “Es una imagen entrelazada muy hermosa de información y entropía”, dijo Lloyd. “La entropía es información que no conocemos; la información es información que sí conocemos”.

En dos hitos papeles. En 1957, el físico estadounidense E.T. Jaynes consolidó esta conexión al considerar la termodinámica a través de la lente de la teoría de la información. Consideraba que la termodinámica era una ciencia que realizaba inferencias estadísticas a partir de mediciones incompletas de partículas. Cuando se conoce información parcial sobre un sistema, propuso Jaynes, deberíamos asignar la misma probabilidad a cada configuración que sea compatible con esas restricciones conocidas. Su «principio de máxima entropía» proporciona la forma menos sesgada de hacer predicciones sobre cualquier conjunto de datos limitado y ahora se emplea en todas partes, desde la mecánica estadística hasta el aprendizaje automático y ecología .

Las nociones de entropía desarrolladas en contextos dispares encajan perfectamente entre sí. Un aumento de la entropía corresponde a una pérdida de información sobre detalles microscópicos. En mecánica estadística, por ejemplo, cuando las partículas de una caja se mezclan y perdemos la pista de sus posiciones y momentos, la “entropía de Gibbs” aumenta. En mecánica cuántica, cuando las partículas se enredan con su entorno, alterando así su estado cuántico, aumenta la “entropía de von Neumann”. Y cuando la materia cae en un agujero negro y la información sobre ella se pierde para el mundo exterior, aumenta la “ entropía de Bekenstein-Hawking ”.

Lo que la entropía mide de forma consistente es la ignorancia: la falta de conocimiento sobre el movimiento de las partículas, el siguiente dígito en una cadena de código o el estado exacto de un sistema cuántico. “A pesar de que las entropías se introdujeron con diferentes motivaciones, hoy podemos vincularlas todas a la noción de incertidumbre”, afirma Renato Renner, físico del Instituto Federal Suizo de Tecnología de Zúrich.

Sin embargo, esta comprensión unificada de la entropía plantea una cuestión inquietante: ¿de qué ignorancia estamos hablando?

Un tufillo a subjetividad

Cuando era estudiante de física en el norte de Italia, Carlo Rovelli aprendió de sus profesores sobre la entropía y el crecimiento del desorden. Algo no cuadraba. Volvió a casa, llenó un frasco con aceite y agua y observó cómo los líquidos se separaban mientras lo agitaba, una aparente desviación de la segunda ley tal como se la habían descrito. “Lo que me están diciendo es una tontería”, recordó haber pensado. “Estaba muy claro que había un problema en la forma en que se enseñaban las cosas”.

La experiencia de Rovelli refleja una de las razones principales por las que la entropía resulta tan desconcertante. Hay muchas situaciones en las que el orden parece aumentar, desde un niño que limpia su dormitorio hasta un frigorífico que enfría un pavo.

Rovelli comprendió que su aparente triunfo sobre la segunda ley era un espejismo. Un observador sobrehumano con una potente visión térmica vería cómo la separación del aceite y el agua libera energía cinética a las moléculas, dejando un estado térmicamente más desordenado. “Lo que realmente está sucediendo es que se está formando un orden macroscópico a expensas del desorden microscópico”, dijo Rovelli. La segunda ley siempre se cumple; a veces simplemente está fuera de la vista.

Jaynes también ayudó a aclarar esta cuestión. Para ello, recurrió a un experimento mental propuesto por primera vez en 1875 por Josiah Willard Gibbs, que se conoció como la paradoja de la mezcla de Gibbs.

Supongamos que tenemos dos gases, A y B, en una caja, separados por un separador. Cuando levantamos el separador, la segunda ley exige que los gases se dispersen y se mezclen, lo que aumenta la entropía. Pero si A y B son gases idénticos mantenidos a la misma presión y temperatura, levantar el separador no cambia la entropía, ya que las partículas ya están mezcladas al máximo.

La pregunta es: ¿Qué pasa si A y B son gases distintos, pero no puedes distinguirlos?

Más de un siglo después de que Gibbs planteara la paradoja, Jaynes presentó una solución. (que según insistió Gibbs ya entendía, pero no logró articular con claridad). Imaginemos que los gases en la caja son dos tipos diferentes de argón, idénticos excepto que uno de ellos es soluble en un elemento aún no descubierto llamado whifnium. Antes del descubrimiento del whifnium, no había forma de distinguir los dos gases, y por lo tanto, levantar el divisor no inicia ningún cambio aparente en la entropía. Sin embargo, después del descubrimiento del whifnium, un científico inteligente podría emplearlo para diferenciar las dos especies de argón, calculando que la entropía aumenta a medida que los dos tipos se mezclan. Además, el científico podría diseñar un pistón basado en whifnium que aproveche la energía previamente inaccesible de la mezcla natural de los gases.

Lo que Jaynes dejó claro es que el “orden” de un sistema –y por lo tanto el potencial para extraer energía útil de él– depende del conocimiento y los recursos relativos de un agente. Si un experimentador no puede distinguir los gases A y B, en realidad son el mismo gas. Tan pronto como los científicos tengan los medios para distinguirlos, pueden aprovechar el trabajo explotando la tendencia de los gases a mezclarse. La entropía no depende de la diferencia entre los gases, sino de su distinguibilidad. El desorden está en el ojo del observador.

“La cantidad de trabajo útil que podemos extraer de cualquier sistema depende —obvia y necesariamente— de cuánta información ‘subjetiva’ tengamos sobre su microestado”, escribió Jaynes.

“La cantidad de trabajo útil que podemos extraer de cualquier sistema depende —obvia y necesariamente— de cuánta información ‘subjetiva’ tengamos sobre su microestado”, escribió Jaynes.

La paradoja de Gibbs enfatiza la necesidad de tratar la entropía como una propiedad perspectivista en lugar de una inherente a un sistema. Y, sin embargo, la imagen subjetiva de la entropía era difícil para que los físicos lo acepten. Como escribió el filósofo de la ciencia Kenneth Denbigh en un libro de texto de 1985 “Una visión así, si fuera válida, crearía algunos problemas filosóficos profundos y tendería a socavar la objetividad de la empresa científica”.

La aceptación de esta definición condicional de la entropía ha exigido un replanteamiento del propósito fundamental de la ciencia, pues implica que la física describe con mayor precisión la experiencia individual que alguna realidad objetiva. De esta manera, la entropía ha sido arrastrada por la tendencia más amplia de los científicos a darse cuenta de que muchas magnitudes físicas sólo tienen sentido en relación con un observador (incluso el tiempo mismo fue relativizado por la teoría de la relatividad de Einstein). “A los físicos no les gusta la subjetividad, son alérgicos a ella”, dijo Anthony Aguirre , físico de la Universidad de California en Santa Cruz. “Pero no existe nada absoluto, eso siempre ha sido una ilusión”.

Ahora que se ha aceptado, algunos físicos están explorando formas de incorporar subjetividad en las definiciones matemáticas de la entropía.

Aguirre y sus colaboradores han ideado una nueva medida que denominan entropía observacional. Ofrece una manera de especificar a qué propiedades tiene acceso un observador determinado, ajustando la forma en que esas propiedades difuminan o “agrandan” la visión que el observador tiene de la realidad. Luego atribuye la misma probabilidad a todos los microestados compatibles con esas propiedades observadas, tal como propuso Jaynes. La ecuación establece un puente entre la entropía termodinámica, que describe características macroscópicas generales, y la entropía de la información, que captura detalles microscópicos. “Este tipo de visión a granel, en parte subjetiva, es la forma en que nos relacionamos con la realidad de una manera significativa”, dijo Aguirre.

Varios grupos independientes han utilizado la fórmula de Aguirre para buscar una solución más riguroso prueba de la segunda ley. Por su parte, Aguirre espera utilizar su medida para explicar por qué el universo comenzó en un estado de baja entropía.(y por lo tanto, por qué el tiempo avanza) y obtener una imagen más clara de lo que significa la entropía en los agujeros negros. “El marco de la entropía observacional proporciona mucha más claridad”, dijo Philipp Strasberg, físico de la Universidad Autónoma de Barcelona, quien recientemente lo incluyó en una comparación de diferentes definiciones de entropía microscópica.“Realmente conecta las ideas de Boltzmann y von Neumann con lo que la gente hace hoy en día”.

Mientras tanto, los teóricos de la información cuántica han adoptado un enfoque diferente. En el caso de los sistemas de partículas, la entropía siempre permanecería constante (ya que no se perdería información ) y el tiempo dejaría de fluir. Pero los observadores con recursos computacionales finitos como nosotros siempre tienen que lidiar con una imagen de la realidad de grano grueso. No podemos seguir el movimiento de todas las moléculas de aire en una habitación, por lo que tomamos promedios en forma de temperatura y presión. Perdemos progresivamente la noción de los detalles microscópicos a medida que los sistemas evolucionan hacia estados más probables, y esta tendencia implacable se materializa como el flujo del tiempo. “El tiempo de la física es, en última instancia, la expresión de nuestra ignorancia del mundo”, escribió Rovelli. La ignorancia compone nuestra realidad.

“Hay un universo ahí fuera, y hay un universo que cada observador lleva consigo: su comprensión y modelo del mundo”, dijo Aguirre. La entropía proporciona un indicador de las deficiencias de nuestros modelos internos. Estos modelos, dijo, “nos permiten hacer buenas predicciones y actuar de manera inteligente en un mundo físico a menudo hostil pero siempre difícil”.

Impulsados por el conocimiento

En el verano de 2023, Aguirre organizó un retiro En las ondulantes colinas de una histórica mansión en Yorkshire, Inglaterra, a través de una organización de investigación sin fines de lucro que cofundó en 2006 llamada Foundational Questions Institute, o FQxI. Físicos de todo el mundo se reunieron para una fiesta de pijamas intelectual de una semana de duración, con oportunidades para practicar yoga, meditación y natación en aguas abiertas. El evento reunió a investigadores que habían recibido subvenciones de FQxI para investigar cómo utilizar la información como combustible.

Para muchos de estos físicos, el estudio de los motores y las computadoras se ha vuelto confuso. Han aprendido a tratar la información como un recurso físico real y cuantificable, un diagnóstico de cuánto trabajo se puede extraer de un sistema. Se dieron cuenta de que el conocimiento es poder. Ahora se proponen aprovechar ese poder.

Una mañana, después de una sesión opcional de yoga en la yurta de la finca, el grupo escuchó a Susanne Still, física de la Universidad de Hawái en Mānoa. Habló de un nuevo trabajo que se remonta a un experimento mental de hace un siglo propuesto por primera vez por el físico nacido en Hungría Leo Szilard.

Imagínese una caja con un divisor vertical que puede deslizarse lateralmente hacia adelante y hacia atrás entre las paredes izquierda y derecha de la caja. Hay una sola partícula en la caja, ubicada a la izquierda del divisor. Cuando la partícula rebota en las paredes, empujará el divisor hacia la derecha. Un demonio astuto puede preparar una cuerda y una polea de manera que, cuando la partícula empuje el divisor, tire de la cuerda y levante un peso fuera de la caja. En este punto, el demonio puede reinsertar disimuladamente el divisor y reiniciar el proceso, lo que habilita una aparente fuente de energía infinita.

Sin embargo, para poder sacar trabajo de la caja de manera consistente, el demonio debe saber en qué lado de la caja se encuentra la partícula. El motor de Szilard está alimentado por información.

En principio, los motores de información son como veleros: en el océano, utilizas tu conocimiento sobre la dirección del viento para ajustar las velas y propulsar el barco hacia adelante.

Pero, al igual que los motores térmicos, los motores de información nunca son perfectos. También ellos deben pagar un impuesto en forma de producción de entropía. La razón por la que no podemos utilizar los motores de información como máquinas de movimiento perpetuo, como señalaron Szilard y otros, es que generan, en promedio, al menos la misma entropía para medir y almacenar esa información. El conocimiento genera poder, pero adquirir y recordar ese conocimiento consume energía.

Unos años después de que Szilard conceptualizara su motor, Adolf Hitler se convirtió en canciller de Alemania. Szilard, que había nacido en una familia judía y había estado viviendo en Alemania, huyó. Su trabajo fue ignorado durante décadas hasta que finalmente fue traducido al inglés, como Still describe en una reciente revisión histórica de motores de información.

Recientemente, al estudiar los ingredientes básicos del procesamiento de la información, Still ha logrado ampliar y generalizar el concepto de Szilard de un motor de información.

Durante más de una década, ha estado trabajando en cómo tratar a los observadores como sistemas físicos, sujetos a sus propias limitaciones físicas. Hasta qué punto se puede llegar a estos límites no solo depende de los datos a los que el observador tiene acceso, sino también de su estrategia de procesamiento de datos. Después de todo, debe decidir qué propiedades medir y cómo almacenar esos detalles en su memoria limitada.

Al estudiar este proceso de toma de decisiones, Still descubrió que la recopilación de información que no ayuda al observador a hacer predicciones útiles disminuye su eficiencia energética. Propuso que los observadores sigan lo que ella llama el “principio del menor impedimento propio”: elegir estrategias de procesamiento de información que se acerquen lo más posible a sus límites físicos para mejorar la velocidad y la precisión de su toma de decisiones. También se dio cuenta de que estas ideas podrían explorarse más a fondo aplicándolas a motores de información modificados.

En el diseño original de Szilard, las mediciones del demonio revelan perfectamente dónde se encuentra la partícula. Sin embargo, en la realidad nunca tenemos un conocimiento perfecto de un sistema porque nuestras mediciones siempre son defectuosas: los sensores están sujetos al ruido, las pantallas tienen una resolución limitada y las computadoras tienen un almacenamiento limitado. Still demostró cómo la «observabilidad parcial» inherente a las mediciones del mundo real se puede introducir con ligeras modificaciones al motor de Szilard, esencialmente cambiando la forma del divisor.

Imagine que el divisor está inclinado en un ángulo dentro de la caja y que el usuario solo puede ver la posición horizontal de la partícula (quizás vea su sombra proyectada sobre el borde inferior de la caja). Si la sombra está completamente a la izquierda o a la derecha del divisor, sabrá con certeza de qué lado está la partícula. Pero si la sombra está en cualquier lugar de la región media, la partícula podría estar por encima o por debajo del divisor inclinado y, por lo tanto, en el lado izquierdo o derecho de la caja.

Utilizando motores de información parcialmente observables, Still calculó las estrategias más eficientes para tomar medidas de la ubicación de la partícula y codificarlas en la memoria. Esto dio como resultado una derivación basada puramente en la física de un algoritmo que también se utiliza actualmente en el aprendizaje automático, conocido como algoritmo de cuello de botella de información . Ofrece una forma de comprimir datos de manera efectiva al preservar solo la información relevante.

Desde entonces, con su estudiante de posgrado Dorian Daimer, Still ha investigado Daimer, que tiene formación en física y en ciencias cognitivas, ha diseñado varios motores Szilard modificados y ha estudiado las estrategias de codificación óptimas en distintos casos. Estos dispositivos teóricos sirven como “bloques fundamentales para la toma de decisiones en condiciones de incertidumbre”. “Por eso me resulta tan interesante estudiar la física del procesamiento de la información, porque, en cierto sentido, se cierra el círculo y se vuelve a describir al científico”.

Industrializarse de nuevo

Still no era el único en Yorkshire que soñaba con los motores de Szilard. En los últimos años, varios becarios de FQxI han desarrollado motores funcionales en el laboratorio en los que se utiliza información para impulsar un dispositivo mecánico. A diferencia de la época de Carnot, nadie espera que estos motores en miniatura impulsen trenes o ganen guerras; en cambio, sirven como bancos de pruebas para investigar la física fundamental. Pero, al igual que la última vez, los motores están obligando a los físicos a reimaginar Qué significa energía, información y entropía.

Con la ayuda de Still, John Bechhoefer ha recreado el motor de Szilard Con una perla de sílice más pequeña que una mota de polvo flotando en un baño de agua, él y sus colegas de la Universidad Simon Fraser en Canadá atrapan la perla con láseres y monitorean sus fluctuaciones térmicas aleatorias. Cuando la perla se mueve hacia arriba, levantan rápidamente la trampa láser para aprovechar su movimiento. Tal como lo imaginó Szilard, lograron levantar un peso aprovechando el poder de la información.

Al investigar los límites Al extraer trabajo de su motor de información del mundo real, Bechhoefer y Still descubrieron que, en ciertos regímenes, puede superar significativamente Los motores convencionales también han detectado la ineficiencia asociada con la recepción de información parcial sobre el estado de la cuenta, inspirado en el trabajo teórico de Still.

Al investigar los límites Al extraer trabajo de su motor de información del mundo real, Bechhoefer y Still descubrieron que, en ciertos regímenes, puede superar significativamente Los motores convencionales también han detectado la ineficiencia asociada con la recepción de información parcial sobre el estado de la cuenta, inspirado en el trabajo teórico de Still.

El motor de la información se reduce ahora a escala cuántica con la ayuda de Natalia Ares, un físico de la Universidad de Oxford que formó parte de un panel Con Still en retirada. En chips de silicio del tamaño de un posavasos, Ares atrapa un único electrón dentro de un fino cable de carbono, que está suspendido entre dos pilares. Este “nanotubo”, que se enfría a milésimas de grado del cero absoluto, vibra como una cuerda de guitarra y su frecuencia de oscilación está determinada por el estado del electrón en su interior. Al rastrear las minúsculas vibraciones del nanotubo, Ares y sus colegas planean diagnosticar el trabajo resultante de diferentes fenómenos cuánticos.

Ares tiene una larga lista de experimentos para investigar la termodinámica cuántica garabateados en pizarrones por todos los pasillos. “Es básicamente toda la revolución industrial, pero en nanotecnología”, dijo. Un experimento planeado se inspira en la idea de Still. Implica ajustar la perfección con la que las vibraciones del nanotubo dependen del electrón (frente a otros factores desconocidos), proporcionando esencialmente un botón para ajustar la ignorancia del observador.

Ares y su equipo están investigando los límites de la termodinámica en las escalas más pequeñas: la fuerza motriz del fuego cuántico, en cierto sentido. Clásicamente, el límite de la eficiencia con la que el movimiento de partículas puede transformarse en trabajo lo establece el teorema de Carnot. Pero en el caso cuántico, con una variedad de entropías En cuanto a la elección, es mucho más complicado determinar cuál de ellos establecerá límites relevantes, o incluso cómo definir la producción de trabajo. “Si tienes un solo electrón, como tenemos en nuestros experimentos, ¿qué significa eso, entropía?”, dijo Ares. “En mi experiencia, todavía estamos muy perdidos en esto”.

Un estudio reciente dirigido por Nicole Yunger Halpern, físico del Instituto Nacional de Estándares y Tecnología, muestra cómo las definiciones comunes de producción de entropía que suelen ser sinónimas pueden discrepar en el ámbito cuántico, nuevamente debido a la incertidumbre y la dependencia del observador. En esta escala diminuta, es imposible conocer ciertas propiedades al mismo tiempo. Y el orden en el que se miden ciertas cantidades puede afectar los resultados de la medición. Yunger Halpern cree que podemos usar esta rareza cuántica en nuestro beneficio. «Hay recursos adicionales disponibles en el mundo cuántico que no están disponibles de manera clásica, por lo que podemos eludir el teorema de Carnot», dice.

Un estudio reciente dirigido por Nicole Yunger Halpern, físico del Instituto Nacional de Estándares y Tecnología, muestra cómo las definiciones comunes de producción de entropía que suelen ser sinónimas pueden discrepar en el ámbito cuántico, nuevamente debido a la incertidumbre y la dependencia del observador. En esta escala diminuta, es imposible conocer ciertas propiedades al mismo tiempo. Y el orden en el que se miden ciertas cantidades puede afectar los resultados de la medición. Yunger Halpern cree que podemos usar esta rareza cuántica en nuestro beneficio. «Hay recursos adicionales disponibles en el mundo cuántico que no están disponibles de manera clásica, por lo que podemos eludir el teorema de Carnot», dice.

Ares está ampliando estos nuevos límites en el laboratorio, con la esperanza de allanar el camino hacia una recolección de energía, una carga de dispositivos o una computación más eficientes. Los experimentos también pueden proporcionar información sobre la mecánica de los sistemas de procesamiento de información más eficientes que conocemos: nosotros mismos. Los científicos no están seguros de cómo el cerebro humano puede realizar ejercicios mentales inmensamente complicados utilizando solo 20 vatios de potencia. Tal vez el secreto de la eficiencia computacional de la biología también resida en el aprovechamiento de fluctuaciones aleatorias a pequeña escala, y estos experimentos apuntan a detectar cualquier posible ventaja. «Si hay alguna ganancia en esto, existe la posibilidad de que la naturaleza realmente lo use», dijo Janet Anders, un teórico de la Universidad de Exeter que trabaja con Ares. “Esperamos que esta comprensión fundamental que estamos desarrollando ahora nos ayude en el futuro a entender mejor cómo funciona la biología”.

La siguiente ronda de experimentos de Ares se llevará a cabo en una cámara de refrigeración de color rosa intenso que cuelga del techo de su laboratorio en Oxford. Hace unos años, sugirió en broma a los fabricantes la renovación, pero estos le advirtieron que las partículas de pintura metálica obstaculizarían sus experimentos. Entonces, la empresa llevó en secreto el frigorífico a un taller de automóviles para cubrirlo con una llamativa película rosa. Ares ve su nuevo espacio experimental como un símbolo de los tiempos cambiantes, que refleja su esperanza de que esta nueva revolución industrial sea diferente de la anterior: más consciente, respetuosa con el medio ambiente e inclusiva.

“Parece como si estuviéramos ante el comienzo de algo grande y maravilloso”, dijo.

Aceptar la incertidumbre

En septiembre de 2024, unos cientos de investigadores se reunieron En Palaiseau, Francia, se celebró un homenaje a Carnot en el 200 aniversario de su libro. Los participantes, procedentes de todos los ámbitos científicos, debatieron sobre la importancia de la entropía en cada una de sus áreas de investigación, desde las células solares hasta los agujeros negros. En el discurso de bienvenida, una directora del Centro Nacional de Investigación Científica de Francia pidió disculpas a Carnot en nombre de su país por haber pasado por alto el impacto de su obra. Más tarde esa noche, los investigadores se reunieron en un comedor dorado y decadente para escuchar una sinfonía compuesta por el padre de Carnot e interpretada por un cuarteto que incluía a uno de los descendientes lejanos del compositor.

La resonante intuición de Carnot surgió de un intento de ejercer un control absoluto sobre el mundo mecánico, el santo grial de la Era de la Razón. Pero a medida que el concepto de entropía se difundió por las ciencias naturales, su propósito cambió. La visión refinada de la entropía es la que se deshace de los falsos sueños de eficiencia total y predicción perfecta y, en cambio, admite la incertidumbre irreducible del mundo. “Hasta cierto punto, nos estamos alejando de la Ilustración en varias direcciones”, dijo Rovelli: del determinismo y el absolutismo y hacia la incertidumbre y la subjetividad.

Nos guste o no, somos esclavos de la segunda ley; no podemos evitar obligar al universo a seguir su destino de desorden supremo. Pero nuestra visión refinada de la entropía nos permite una perspectiva más positiva. La tendencia al desorden es lo que impulsa todas nuestras máquinas. Si bien la decadencia de la energía útil limita nuestras capacidades, a veces una nueva perspectiva puede revelar una reserva de orden oculta en el caos. Además, un cosmos desordenado es uno que está cada vez más lleno de posibilidades. No podemos eludir la incertidumbre, pero podemos aprender a manejarla, y tal vez incluso aceptarla. Después de todo, la ignorancia es lo que nos motiva a buscar el conocimiento y construir historias sobre nuestra experiencia. La entropía, en otras palabras, es lo que nos hace humanos.

Puedes lamentar el inevitable colapso del orden, o puedes aceptar la incertidumbre como una oportunidad para aprender, sentir y deducir, tomar mejores decisiones y aprovechar tu poder motriz.