Legisladores de la Ciudad de Buenos Aires aprobaron una modificación de la ley del Sistema Integral de Seguridad Pública, que regula el uso de cámaras de videovigilancia y tecnologías de reconocimiento facial en el espacio público. Organizaciones civiles advierten que esta medida legitima prácticas que amenazan derechos ciudadanos y reclaman por la falta de un debate amplio y transparente.

Por Vanina Lombardi

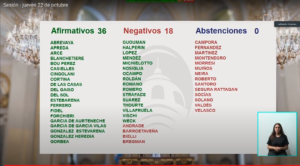

Agencia TSS – Con mayoría de legisladores del oficialismo y aliados, fines de octubre se aprobó la reforma de la Ley 5688, del Sistema Integral de Seguridad Pública en la Legislatura de la Ciudad de Buenos Aires. La modificación regula, entre otros aspectos, el sistema de cámaras de videovigilancia desplegadas en el espacio público y el uso de tecnologías de reconocimiento facial, un método que es cuestionado y debatido tanto en la Argentina como en distintas partes del mundo y cuya implementación, incluso, ha sido limitada o prohibida. El caso más reciente es el de la ciudad de Portland, en Estados Unidos.

“Nos hubiese gustado que este tema se promoviera de una manera más abierta y plural, pero más allá del trabajo que hicimos las organizaciones de la sociedad civil, reuniéndonos específicamente con legisladoras y legisladores, y de la llegada limitada que tenemos para informar a la gente por nuestros canales de comunicación, no hubo discusión”, lamentó Leandro Ucciferri, de la Asociación por los Derechos Civiles (ADC), y advirtió que, junto con otras organizaciones civiles como Access Now, Amnistía Internacional, el Centro de Estudios Legales y Sociales (CELS), DATAS, Fundación Vía Libre y el Observatorio de Derecho Informático Argentino (ODIA), cuestionaron el proyecto de modificación y promovieron que sea debatido de manera profunda y abierta en la sociedad, incluyendo la perspectiva de los derechos humanos.

Entre otras modificaciones, la nueva regulación incorpora el artículo 480 (bis), que establece que el Sistema de Reconocimiento Facial de Prófugos (SRFP) “será empleado únicamente para tareas requeridas por el Ministerio Público Fiscal, el Poder Judicial de la Nación, Provincial y de la Ciudad Autónoma de Buenos Aires, como así también para detección de personas buscadas exclusivamente por orden judicial, registradas en la Base de Datos de Consulta Nacional de Rebeldías y Capturas (CONARC)”. Esta última es una base de datos pública con más de 40.000 registros, que depende del Registro Nacional de Reincidencia (RNR).

Otro cambio de la nueva normativa es que, en su artículo 490, agrega que la autoridad de aplicación deberá remitir una vez por año, como mínimo, a la Comisión de Seguimiento del Sistema de Seguridad Pública y a la Defensoría del Pueblo, información referente a las especificaciones técnicas del software de reconocimiento facial utilizado, las modificaciones técnicas que pudiera haber en las características de los dispositivos y el criterio de instalación y/o continuidad de los sistemas de videovigilancia.

“Eso no es suficiente, hacen falta muchas salvaguardas”, advirtió Ucciferri, y agregó: “Una de las grandes cuestiones, cuando hablamos de estas tecnologías, es cuánto sirven para resolver los problemas que buscan resolver. Es necesaria una evaluación, que no se realizó, para entender no solo cómo impacta en derechos humanos, sino también si es la mejor solución para el problema que se quiere resolver, que no es reducir el crimen, sino encontrar gente que está prófuga de la Justicia”.

Según declaraciones del secretario de Seguridad del Ministerio de Seguridad y Justicia de Buenos Aires, Marcelo D’Alessandro, a Chequeado, al 4 de marzo de 2020 el sistema había identificado y puesto a disposición de la justicia a 1924 personas, de las cuales 418 quedaron detenidas. Sin embargo, producto de este sistema, también hubo retenciones y demoras a personas inocentes, debido principalmente a errores en la base de datos de CONARC.

Esta base de datos ya había sido cuestionada por organizaciones civiles, por la Defensoría del Pueblo y hasta por el relator especial de la ONU sobre el derecho a la privacidad, Joseph Cannataci, en su visita a la Argentina, en mayo del año pasado. “Soy consciente de la necesidad de detener a las personas sospechosas de haber cometido delitos y llevarlas ante la Justicia, pero no veo la proporcionalidad de instalar una tecnología con graves implicaciones para la privacidad para buscar en una lista de 46.000 personas que actualmente incluye a menores y delitos no graves, y que no se actualice y compruebe cuidadosamente su exactitud”, dijo entonces Cannataci, en declaraciones a los medios.

“Que exista una ley no hace que el sistema sea constitucional o legítimo. Lo que queda ahora es analizar cómo esta reforma no cumple con los estándares constitucionales que debería y ver si es posible presentar algún tipo de demanda judicial”, consideró Uciferri, aunque reconoció que estos procesos son largos. “Mientras tanto, nos sigue preocupando muchísimo que el Gobierno porteño, en los intercambios que hemos tenido, nunca nos supo explicar cómo logrará evitar que se siga deteniendo a gente inocente por problemas en cómo está pensado el sistema”. Desde ADC tampoco lograron que el Gobierno les detallara la metodología con la cual miden la efectividad del sistema, los falsos positivos ni otros datos como estadísticas concretas sobre cuántas alertas se generaron o de cuántas personas llevan a la Justicia.

Entre la probabilidad y el error

A pesar de las controversias que generan las tecnologías de reconocimiento facial, en los últimos años han comenzado a utilizarse en distintos países. En América Latina, por ejemplo, Paraguay cuenta con 54 cámaras con capacidades operadas por la Policía Nacional en la zona metropolitana de Asunción. En el año 2019, Chile lanzó un “Sistema de Vigilancia Móvil” para la región metropolitana de Santiago, que incluye 154 cámaras con reconocimiento facial, lectores de patentes de autos y cuatro centros de monitoreo. Ecuador, en tanto, comenzó pruebas piloto con esta tecnología para monitorear cinco zonas de Quito.

El año pasado, Buenos Aires había empezado a utilizar el reconocimiento facial con 300 cámaras en la vía pública, con el objetivo de identificar a personas con orden de detención de la Justicia que figuren en la CONARC. Si bien este sistema se encuentra suspendido desde abril de este año, debido a la pandemia, fue implementado el 24 de abril de 2019 a través de la Resolución 398, mediante un desembolso de US$ 1,51 millón en 17 meses para la empresa Danaide, que a través de un procedimiento de contratación directa obtuvo la prestación del servicio que ejecuta la Policía Metropolitana.

“El Gobierno de la Ciudad de Buenos Aires consideró tácitamente que, si podía poner cámaras en el espacio público, también podía incluir reconocimiento facial en ellas, lo que desde el punto de vista jurídico es extremadamente discutible”, dijo Enrique Chaparro, de Fundación Vía Libre, que también cuestionó las modificaciones aprobadas a fines del mes pasado, y explicó que existe una protección constitucional de la vida privada y que las acciones privadas no son sólo las que suceden dentro del ámbito doméstico, sino que se refieren a todo aquello que la persona intenta reservar para sí o determinar de manera más o menos exclusiva a quién se lo comunica.

Además, Chaparro se refirió a los mecanismos de identificación de las personas en el espacio público: “Por la misma razón que consideramos que es un atropello que la policía pida documentos en la calle, esto es el equivalente: es como un policía invisible que le pide documentos a todos. Incluso es más grave, porque atenta contra la presunción de inocencia de las personas”, agregó y sintetizó: “Nadie se opone a vivir en una ciudad más segura, pero no debe serlo a expensas de las libertades públicas ni de un criterio de selectividad que identifica de antemano”.

Ucciferri consideró que el uso de estas tecnologías implica redefinir cómo disfrutamos del espacio público en sí. Por eso, enfatizó sobre la necesidad de que la sociedad cuente con un espacio para reflexionar sobre las implicancias de estos sistemas: “Si el hecho de que se alteren garantías constitucionales, como la presunción de inocencia o el debido proceso, ofrece realmente un beneficio sustancial o si es algo que la sociedad quiere y por qué”, ejemplificó el especialista. “Lo más grave es la reversión de la carga de la prueba, porque, al tener que descartar a todas las personas que pasan frente a la cámara que no son culpables, lo que se está haciendo es presumir que todos son culpables hasta que el sistema diga lo contrario”, dijo.

Junto con estas cuestiones vinculadas con el derecho a la privacidad y la presunción de inocencia, hay otras no menos relevantes que merecen ser analizadas en profundidad. Se trata de la eficacia del sistema y sus limitaciones tecnológicas. Las denominadas tecnologías biométricas, como la huella dactilar, los rasgos faciales, la manera de caminar, la manera de escribir en el teclado y el movimiento del iris, tienen un margen de error que desemboca en falsos positivos, es decir, la cantidad de veces que identifica a una persona por otra.

La capacidad de reconocimiento de estos algoritmos también puede estar sesgada. “Los sistemas de reconocimiento facial funcionan mediante técnicas de aprendizaje. El problema detectado y documentado es que esta técnica tiene un sesgo muy fuerte, entonces son mucho más precisos identificando hombres blancos. A medida que el color de piel se oscurece, la precisión de la identificación disminuye y hay un salto importante en los niveles de error”, argumentó Chaparro.

“La sociedad debería tener la evidencias de cuáles fueron los otros medios que se descartaron para realmente convencerse de que esta es la mejor manera de resolver este problema. Así deberían construirse las políticas públicas. En cambio, la Legislatura terminó convalidando este sistema que fue impuesto de manera unilateral”, cuestionó Ucciferri. “Fue una contratación directa a una empresa, con un sistema que no se discutió públicamente y que la Legislatura no analizó en detalle para entender cómo regular esto ni de qué manera hacerlo”, concluyó.