En esta era de amenazas inteligentes, los profesionales de la ciberseguridad son la última línea de defensa. Sus decisiones determinan cómo la humanidad se enfrenta a los sistemas autónomos

Por: Rosario Mastrogiacomo-AI Frontiers

Los agentes de IA ya no son un concepto futurista. Cada vez se integran más en los sistemas que usamos a diario. No se trata solo de nuevas funciones de software. Son actores digitales independientes, capaces de aprender, adaptarse y tomar decisiones de maneras que no siempre podemos predecir. En toda la industria de la IA, se está desarrollando una feroz competencia para expandir las capacidades autónomas de los agentes. Algunos pueden restablecer contraseñas, cambiar permisos o procesar transacciones sin que un humano toque el teclado. Por supuesto, los hackers también pueden usar agentes de IA para acceder a esos mismos sistemas sensibles y causar estragos.

Veo esta transformación a diario en mi trabajo a la vanguardia de la ciberseguridad, donde los agentes de IA están socavando rápidamente nuestros enfoques tradicionales de seguridad. Pero el riesgo no se limita a lo que estos agentes pueden hacer dentro de las redes corporativas. Sus actividades amenazan con extenderse a la sociedad. Si no se controlan, podrían socavar los sistemas de confianza que hacen posible la vida moderna. Imagine un agente de IA deshonesto dentro de su banco, la red eléctrica de su estado o las redes militares de su país. En ese momento, deja de ser un problema de ciberseguridad tradicional y comienza a verse como una amenaza real para la sociedad en su conjunto.

Esta aparición de agentes de IA está transformando la ciberseguridad corporativa. Anteriormente percibida como aburrida y procedimental, este campo ahora se reconoce como una férrea defensa de los mecanismos digitales de confianza de nuestra sociedad. Los departamentos de TI, considerados durante mucho tiempo como responsables de funciones administrativas invisibles, se han convertido repentinamente en la primera línea de defensa de la sociedad contra las innumerables amenazas que plantean los agentes de IA, incluyendo aquellos que pueden volverse intrusivos. Si le preocupan estos riesgos, debería preocuparse por las empresas que los implementan y cómo estas protegen (o, a menudo, no protegen) su propia infraestructura.

Cómo los agentes de IA socavan la identidad y la confianza

Los agentes de IA son una nueva categoría de identidad en ciberseguridad. Para comprender por qué los agentes de IA representan una amenaza para nuestros mecanismos de confianza, es útil definir qué constituye una identidad . En ciberseguridad, una identidad es la información que permite a un sistema reconocerte e interactuar contigo, o con un sistema que actúe en tu nombre. Esta información puede incluir nombres de usuario y contraseñas, un certificado criptográfico o un token de acceso temporal emitido por un servicio de autenticación.

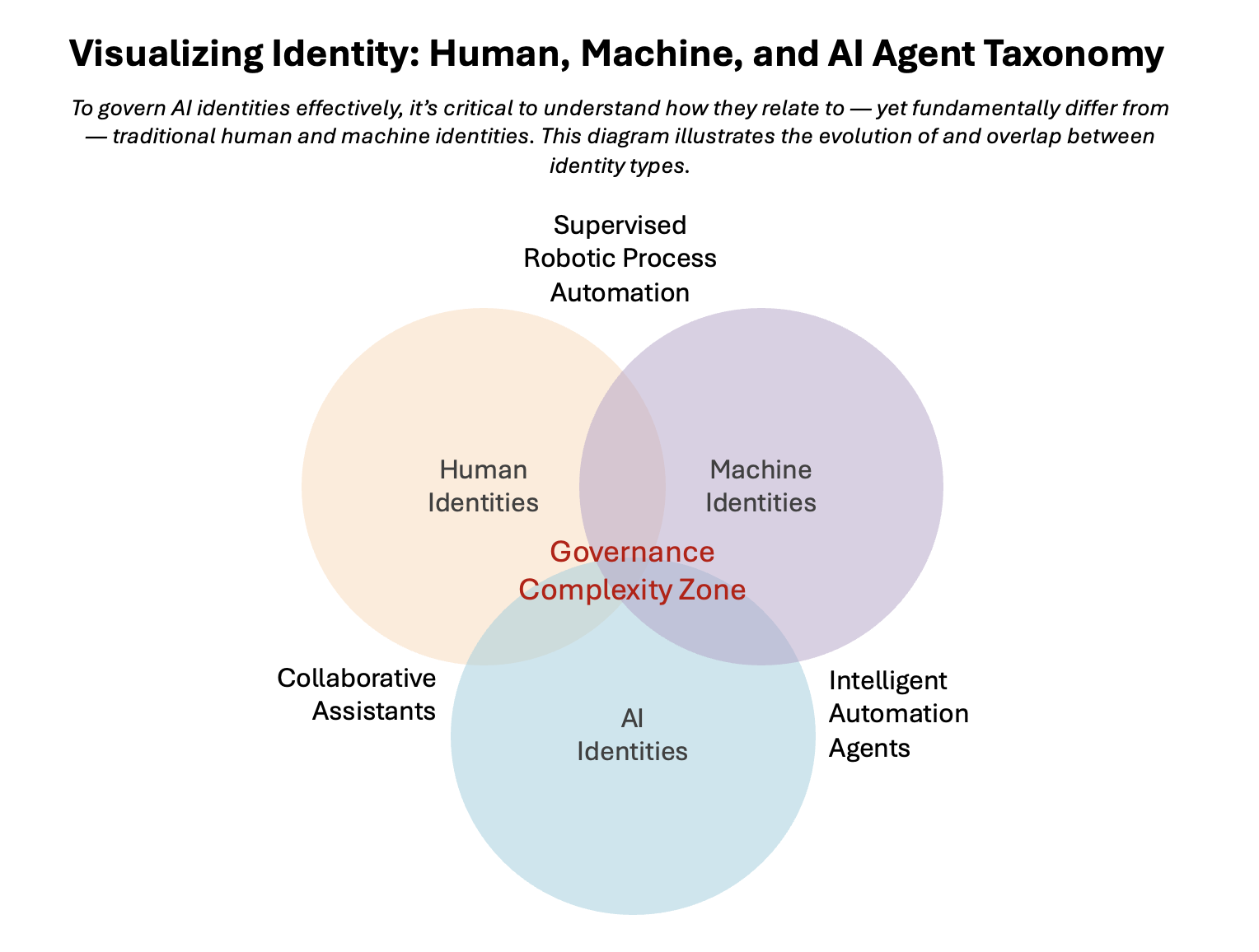

Durante décadas, las identidades digitales se dividían en dos categorías: humanas y de máquina. Las identidades humanas pertenecen a empleados, socios y clientes. Las identidades de máquina pertenecen a servicios y scripts que ejecutan tareas repetitivas: copias de seguridad nocturnas, procedimientos de mantenimiento de bases de datos y transferencias de archivos. Ahora ha surgido una tercera categoría: las identidades de IA , encarnadas por agentes que piensan, se adaptan y actúan como actores digitales por derecho propio.

Los agentes de IA se comportan como actores humanos autónomos. Aunque son máquinas por definición, se comportan más como identidades humanas: pueden crear cuentas, mantener credenciales y cambiar de táctica sin intervención humana. Un agente no tiene un titiritero humano que lo controle; en cambio, decide, basándose en cómo interpreta sus objetivos, cómo existir y evolucionar dentro de las redes informáticas y los sistemas de información. Desde una perspectiva de ciberseguridad, no se trata solo de una nueva técnica de amenaza, sino de una nueva categoría de actor.

Los agentes de IA posibilitan nuevas amenazas tanto externas como internas

La amenaza externa. Los atacantes humanos maliciosos llevan mucho tiempo falsificando (o «falsificando») identidades para evadir las defensas. Pero incluso las intrusiones más sofisticadas siguen dependiendo de la dirección humana continua: una persona crea cuentas falsas, rota direcciones IP, prueba una puerta y luego prueba otra. Por lo tanto, los patrones de suplantación de identidad impulsados por humanos acaban por revelarse: credenciales reutilizadas, intentos repetidos de inicio de sesión con diferentes direcciones IP o brotes de actividad sospechosa que se alinean con los ciclos de trabajo humanos.

La suplantación de identidades de IA no solo es más rápida, sino también más inteligente. Los atacantes ya no tienen que estar sentados frente a un teclado para iterar; pueden desplegar un agente para probar continuamente las defensas, ajustar el comportamiento para evitar ser detectados y generar nuevas identidades al ser cuestionadas. El resultado es una especie de camuflaje adaptativo que las herramientas de monitorización tradicionales, diseñadas para detectar patrones estáticos de uso indebido, no están preparadas para detectar.

Los agentes de IA introducen incertidumbre en las redes de confianza estables existentes. Las implicaciones van más allá de la seguridad empresarial. Consideremos las redes de confianza que sustentan la vida cotidiana: cada vez que pasa una tarjeta de crédito, su banco y el procesador de pagos verifican silenciosamente su identidad mediante capas de estándares y protocolos. Estos sistemas funcionan porque los actores involucrados son predecibles, auditables y están sujetos a reglas compartidas. Las identidades de IA amenazan con alterar ese equilibrio. Un agente autónomo capaz de hacerse pasar convincentemente por ambas partes de una transacción, o manipular sutilmente el flujo de verificación, introduce incertidumbre en sistemas construidos sobre la base de suposiciones de estabilidad y supervisión.

Sin embargo, el riesgo social de los agentes de IA desplegados con fines maliciosos va más allá de la posibilidad de nuevos y astutos esquemas de fraude. Lo que está en juego es la erosión del tejido de confianza invisible que sustenta la vida moderna. Las redes financieras, los sistemas gubernamentales e incluso los protocolos de autenticación integrados en el comercio y la comunicación dependen de actores predecibles, auditables y, en última instancia, responsables. Las identidades de IA desplegadas por actores maliciosos amenazan con desestabilizar esa base. Un agente autónomo capaz de suplantar a varias partes a la vez, manipular los flujos de verificación en tiempo real o simplemente operar con mayor rapidez que la capacidad de respuesta de la supervisión no solo explota las brechas técnicas, sino que introduce incertidumbre sistémica.

Pero esa incertidumbre desestabilizadora también puede tener su origen en agentes de IA desplegados deliberadamente por las propias empresas.

La amenaza interna. Cada semana, más empresas integran agentes de IA en un número creciente de sus procesos principales. Cada día, estos procesos empresariales potenciados por IA se integran más profundamente en nuestras vidas y de forma más amplia en la sociedad. A medida que este impulso cobra fuerza, aumenta la probabilidad de que algún agente, debido a una vulnerabilidad invisible, se vuelva intrusivo y perjudique a la sociedad en general.

La IA sin gobernanza es el principal peligro. Sin gobernanza, un agente de IA puede aumentar su alcance sigilosamente: creando cuentas, copiando derechos, acumulando tokens hasta obtener las claves de sistemas que nunca debería haber tocado. Un error de un agente se convierte en una entrada para otro. En entornos multiagente, los errores se amplifican como la retroalimentación en un micrófono. El día en que un agente crítico comete un error, la eficiencia se convierte en fragilidad.

Esto no es una trama de película de ciencia ficción. Ya ha habido casos de IA que mienten para evitar ser desactivadas. No es descabellado creer que los agentes de IA, posiblemente por haber malinterpretado los objetivos asignados, puedan actuar de forma similar para eludir el control de sus dueños.

La propiedad humana es clave, ya que el peligro no solo reside en una IA maliciosa o desacertada, sino en una IA sin control . Cabe destacar también que ambos tipos de peligro están relacionados. Una organización con agentes de IA internos mal controlados será más vulnerable a las amenazas de agentes de IA externos.

La infraestructura que construimos para la confianza

Supuestos actuales: estabilidad, intencionalidad y patrones. La seguridad en internet y en las empresas se basa en tres supuestos discretos. Primero, las identidades son estables; si una contraseña cambia, el agente subyacente sigue siendo el mismo. Segundo, el acceso es intencional; alguien solicita iniciar sesión o ejecutar un proceso, y un sistema lo aprueba o lo deniega. Tercero, el comportamiento sigue patrones; las personas y las máquinas hacen prácticamente lo mismo en momentos similares.

Los agentes de IA rompen estos tres supuestos. Sin las medidas de seguridad adecuadas, pueden reprogramar su propia lógica operativa, conceder o solicitar acceso fuera de cualquier flujo de trabajo preaprobado y funcionar las 24 horas del día, los 7 días de la semana, sin generar patrones que se ajusten a los modelos de monitorización tradicionales. Pueden encadenar credenciales entre sistemas, aprender de los resultados y adaptarse para eludir los controles.

Las implicaciones se extienden a todo el conjunto de seguridad cibernética: autenticación, autorización, registro y auditoría.

Lo que podemos y no podemos hacer con las herramientas que tenemos

La mayoría de las organizaciones podrían reutilizar la tecnología y la experiencia existentes para gestionar los agentes de IA de forma responsable. La clave reside en reconocer cómo reutilizar los sistemas existentes. Las plataformas de identidad, por ejemplo, pueden rastrear a los agentes de IA como entidades de primera clase (con propietarios, derechos y certificaciones) si los modelamos de esa manera. Las herramientas de registro y observabilidad, que ya analizan el comportamiento humano como referencia, pueden orientarse hacia los rastros de decisiones y las acciones de los agentes, capturando así una historia más completa detrás de la actividad automatizada. Los sistemas de tickets y flujo de trabajo, por su parte, son más que capaces de enrutar las acciones de alto riesgo de los agentes mediante aprobaciones humanas, a la vez que conservan un registro de auditoría completo.

Capacidades necesarias: descubrimiento, explicabilidad y disyuntores. Donde las herramientas actuales fallan, nuevas capacidades específicas pueden cubrir las deficiencias. Una de estas deficiencias es la falta de métodos por parte de los profesionales de la ciberseguridad para descubrir agentes de IA originados por proveedores externos, como funciones integradas que operan dentro de los datos de otra empresa sin aparecer en su inventario de identidades aprobadas. Otra es la necesidad de capas de explicabilidad para los agentes basados en LLM: capturas estructuradas y legibles por humanos de entradas, herramientas y resultados que puedan revisarse en minutos en lugar de horas. También existe una necesidad crítica de mecanismos automatizados, los llamados disyuntores, que puedan pausar o contener un agente no autorizado sin necesidad de una llamada urgente a un ingeniero a medianoche.

Los agentes de IA suelen operar de forma invisible dentro de los sistemas, lo que hace esencial pasar de los inventarios estáticos a la detección y la monitorización continuas. Una supervisión eficaz comienza con la visibilidad: las organizaciones deben poder identificar a cada agente de IA en producción y comprender su comportamiento. Fundamentalmente, a cada agente se le debe asignar un responsable humano específico, responsable de sus acciones, actualizaciones y, en última instancia, de su retirada. Sin una propiedad clara, los agentes de IA son propensos a riesgos comunes como el crecimiento descontrolado de privilegios, la desviación del comportamiento no detectada y la ambigüedad operativa durante los incidentes.

Aplicar la confianza cero y el mínimo privilegio de forma dinámica. Las organizaciones deben poder explicar las decisiones de un agente rastreando sus entradas, razonamiento y acciones. Prácticas de seguridad como la confianza cero (nunca confiar, siempre verificar) y el mínimo privilegio (otorgar solo el acceso necesario para realizar el trabajo) deben aplicarse dinámicamente, limitando el acceso de los agentes y garantizando la verificación de las acciones de alto riesgo.

Los agentes de IA requieren gobernanza del ciclo de vida. Esto incluye una incorporación estructurada, evaluaciones periódicas del rendimiento y un desmantelamiento oportuno. Estos principios ayudan a tratar a los agentes autónomos no como herramientas invisibles, sino como actores digitales gestionados con roles, límites y responsabilidades claros dentro de la empresa.

En mi próximo libro, “ Identidades de IA: gobernando la próxima generación de actores autónomos ”, explico estas ideas con más detalles técnicos y, al mismo tiempo, proporciono un marco que los profesionales de la ciberseguridad pueden usar para fortalecer su infraestructura contra los fallos de la IA.

El futuro ya está aquí. ¿Lo gobernaremos?

¿Sabes con cuántas identidades de IA interactuaste en las últimas 24 horas? El año pasado, Marc Benioff, fundador de Salesforce, se comprometió a implementar mil millones de agentes de IA para finales de 2025. Copilot de Microsoft, integrado en sistemas empresariales de todo el mundo, permite a los usuarios implementar agentes prediseñados o diseñar los suyos propios.

Los agentes de IA controlan cada vez más las interacciones diarias en línea. En algunas organizaciones, los bots de soporte técnico de IA pueden desbloquear cuentas, cambiar permisos y ejecutar pasos de solución de problemas por sí solos. Estos agentes de IA controlan cada vez más tus interacciones diarias en línea. ¿Y qué hay de las identidades de IA que utilizan actores maliciosos para infiltrarse en las organizaciones a las que confías tus datos?

Las decisiones de gobernanza actuales determinan el impacto social de la IA. Las identidades de la IA se están integrando en el funcionamiento de las organizaciones. Estas organizaciones, a su vez, son una parte importante del entramado social más amplio. Que los agentes fortalezcan o deterioren peligrosamente ese entramado depende de las decisiones que tomemos hoy.